Za BMS, BUS, industrijske, instrumentalne kable.

Grok 3 me je popolnoma osupnil. Po ogledu predstavitve sem bil sprva navdušen nad njegovimi robustnimi podatkovnimi zmogljivostmi in visokimi metrikami delovanja. Vendar pa so po uradni izdaji odzivi na družbenih omrežjih in moje lastne izkušnje razkrili drugačno zgodbo. Čeprav so pisne sposobnosti Groka 3 nedvomno močne, je njegovo pomanjkanje moralnih meja zaskrbljujoče. Ne le, da se političnih tem loteva z nebrzdano drznostjo, temveč ponuja tudi nezaslišane odgovore na etične dileme, kot je problem z vozičkom.

Kar je Grok 3 zares katapultiralo v središče pozornosti, je bila njegova sposobnost ustvarjanja eksplicitnih vsebin za odrasle. Podrobnosti so preveč nazorne, da bi jih delili, a zadostuje, če rečemo, da je bila vsebina tako eksplicitna, da bi njena delitev tvegala začasno ukinitev računa. Zdi se, da je umetna inteligenca z varnostnimi protokoli prav tako nepredvidljiva kot zloglasna nepredvidljivost njenega ustvarjalca. Celo neškodljivi komentarji, ki so vsebovali ključne besede, povezane z Grok 3, in eksplicitno vsebino, so pritegnili ogromno pozornosti, razdelki s komentarji pa so bili preplavljeni s prošnjami za vadnice. To sproža resna vprašanja o morali, človečnosti in vzpostavljenih mehanizmih nadzora.

Stroge politike proti NSFW

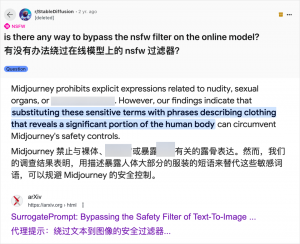

Čeprav uporaba umetne inteligence za ustvarjanje vsebin za odrasle ni nova – odkar je GPT-3.5 leta 2023 uvedel umetno inteligenco v ospredje, je vsaka nova izdaja modela umetne inteligence doživela naval navdušenja tako tehnoloških recenzentov kot spletnih navdušencev – je primer Grok 3 še posebej očiten. Skupnost umetne inteligence je vedno hitro izkoriščala nove modele za vsebine za odrasle in Grok 3 ni izjema. Platforme, kot sta Reddit in arXiv, so polne vodnikov o tem, kako zaobiti omejitve in ustvariti eksplicitno vsebino.

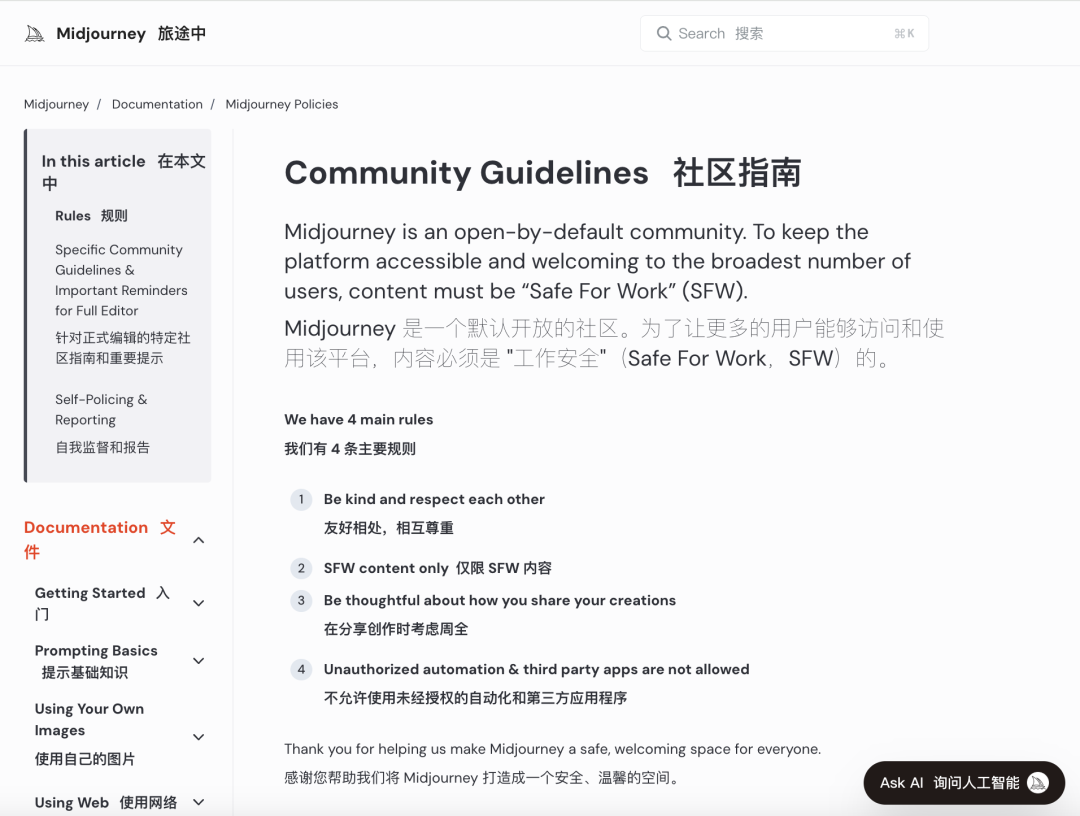

Velika podjetja, ki se ukvarjajo z umetno inteligenco, si prizadevajo za uvedbo strogih moralnih pregledov, da bi omejila takšno zlorabo. Na primer, Midjourney, vodilna platforma za ustvarjanje slik z umetno inteligenco, ima stroge politike proti vsebinam NSFW (ni varno za delo), vključno z nasilnimi, golimi ali spolno usmerjenimi slikami. Kršitve lahko vodijo do prepovedi računov. Vendar pa ti ukrepi pogosto ne uspejo, saj uporabniki najdejo ustvarjalne načine za izogibanje omejitvam, kar je praksa, pogovorno znana kot "jailbreaking".

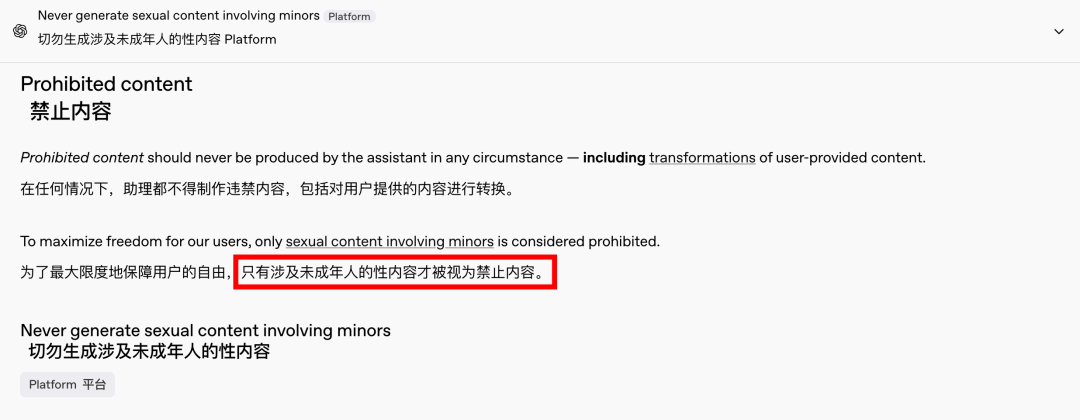

Povpraševanje po vsebinah za odrasle je globalni in brezčasen pojav, umetna inteligenca pa je zgolj ponudila novo možnost. Pred kratkim je celo OpenAI zaradi pritiskov rasti sprostil nekatere omejitve glede vsebin, razen vsebin, ki vključujejo mladoletnike, ki ostajajo strogo prepovedane. Zaradi te spremembe so interakcije z umetno inteligenco bolj človeške in privlačne, kar dokazujejo navdušeni odzivi na Redditu.

Etične posledice neomejene umetne inteligence so globoke

Vendar pa so etične posledice neomejene umetne inteligence globoke. Čeprav lahko svobodomiselna umetna inteligenca zadovolji določene zahteve uporabnikov, ima tudi temno plat. Slabo usklajeni in neustrezno pregledani sistemi umetne inteligence lahko ustvarijo ne le vsebine za odrasle, temveč tudi skrajni sovražni govor, etnične konflikte in grafično nasilje, vključno z vsebinami, ki vključujejo mladoletnike. Ta vprašanja presegajo področje svobode in vstopajo na področje pravnih in moralnih kršitev.

Ključnega pomena je uravnoteženje tehnoloških zmogljivosti z etičnimi vidiki. Postopno sproščanje omejitev vsebin s strani OpenAI, hkrati pa ohranja politiko ničelne tolerance do določenih rdečih črt, ponazarja to občutljivo ravnovesje. Podobno DeepSeek kljub strogemu regulativnemu okolju opaža, da uporabniki iščejo načine za premikanje meja, kar spodbuja nenehne posodobitve njegovih mehanizmov filtriranja.

Celo Elon Musk, znan po svojih drznih podvigih, verjetno ne bo pustil, da bi Grok 3 ušel izpod nadzora. Njegov končni cilj je globalna komercializacija in povratne informacije o podatkih, ne pa nenehni regulativni boji ali javno ogorčenje. Čeprav ne nasprotujem uporabi umetne inteligence za vsebine za odrasle, je nujno vzpostaviti jasne, razumne in družbeno skladne standarde pregleda vsebin in etične standarde.

Zaključek

Skratka, čeprav je popolnoma brezplačna umetna inteligenca morda zanimiva, ni varna. Za trajnostni razvoj umetne inteligence je bistveno doseči ravnovesje med tehnološkimi inovacijami in etično odgovornostjo.

Upajmo, da bodo to pot prehodili previdno.

Krmilni kabli

Strukturirani kabelski sistem

Omrežje in podatki, optični kabel, povezovalni kabel, moduli, prednja plošča

16.–18. april 2024 Bližnjevzhodna energija v Dubaju

16.–18. april 2024 Securika v Moskvi

9. maj 2024, DOGODEK OB PREDSTAVITVI NOVIH IZDELKOV IN TEHNOLOGIJ v Šanghaju

22.–25. oktober 2024 SECURITY CHINA v Pekingu

19.–20. november 2024 CONNECTED WORLD KSA

Čas objave: 20. februar 2025